Amazon Web Services (AWS) en NVIDIA hebben vandaag aangekondigd dat ze hun strategische samenwerking uitbreiden om geavanceerde infrastructuur, software en diensten te bieden ter ondersteuning van generatieve kunstmatige intelligentie (AI) innovaties. Deze aankondiging, gedaan tijdens AWS re:Invent, vertegenwoordigt een belangrijke mijlpaal in de wereld van AI en cloud computing.

De samenwerking tussen AWS, een dochteronderneming van Amazon.com, Inc., en NVIDIA, een toonaangevend technologiebedrijf, brengt de sterke punten van beide organisaties samen en is gericht op het versnellen van vooruitgang in generatieve AI-technologieën. Dit partnerschap is geworteld in een langdurige relatie die heeft bijgedragen aan de vooruitgang van generatieve AI.

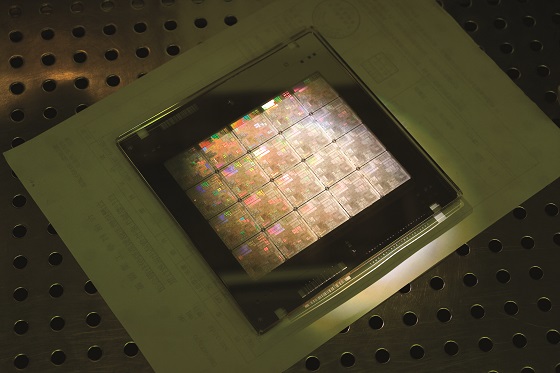

Een van de opvallende aankondigingen is dat AWS de eerste cloudprovider wordt die NVIDIA GH200 Grace Hopper Superchips aanbiedt, voorzien van nieuwe multi-node NVLink-technologie. Deze geavanceerde chips zullen beschikbaar zijn op Amazon Elastic Compute Cloud (Amazon EC2) instanties, waarbij ze profiteren van de krachtige netwerkmogelijkheden van Amazon (EFA), geavanceerde virtualisatie (AWS Nitro System) en hyper-scale clustering (Amazon EC2 UltraClusters). Dit stelt gezamenlijke klanten in staat om op te schalen naar duizenden GH200 Superchips, wat essentieel is voor grootschalige AI-modeltraining.

Daarnaast zal NVIDIA DGX Cloud, een AI-trainingsdienst, beschikbaar zijn op AWS. Het zal de eerste DGX Cloud zijn met GH200 NVL32, wat ontwikkelaars toegang geeft tot het grootste gedeelde geheugen in één instantie. DGX Cloud op AWS zal de training van geavanceerde generatieve AI-modellen versnellen, inclusief grote taalmodellen met meer dan een biljoen parameters.

Een andere belangrijke samenwerking betreft Project Ceiba, waarbij AWS en NVIDIA werken aan het ontwerpen van ’s werelds snelste GPU-aangedreven AI-supercomputer. Dit unieke supercomputersysteem zal GH200 NVL32-technologie bevatten en gebruikmaken van de Amazon EFA-interconnect. Het zal worden ingezet door NVIDIA voor hun eigen onderzoek en ontwikkeling, met name in het veld van generatieve AI.

Naast deze hardware-aankondigingen zal AWS ook drie nieuwe Amazon EC2-instantietypes introduceren. Deze instanties zullen worden aangedreven door NVIDIA GH200, H200, L40S en L4 GPU’s en zullen geschikt zijn voor diverse AI-, high-performance computing (HPC)-, ontwerp- en simulatiewerklasten.

Bovendien zal NVIDIA software beschikbaar stellen op AWS om de ontwikkeling van generatieve AI te ondersteunen, waaronder het NeMo LLM-framework, NeMo Retriever microservice en BioNeMo. Deze tools zullen de ontwikkeling van aangepaste modellen, semantische zoekopdrachten en medicijnontdekking in het veld van generatieve AI verbeteren.

Deze uitgebreide samenwerking tussen AWS en NVIDIA markeert een belangrijke stap in het bevorderen van generatieve AI-technologieën en het bieden van de benodigde tools en infrastructuur voor innovatie in verschillende sectoren. Door hun expertise en middelen te bundelen, streven beide bedrijven ernaar om AWS de voorkeursbestemming te maken voor het uitvoeren van GPU’s en zo bij te dragen aan de ontwikkeling van generatieve AI-mogelijkheden over de hele wereld.

Deze aankondigingen, gedaan tijdens AWS re:Invent, benadrukken het belang van deze samenwerking in het voortdurend evoluerende landschap van kunstmatige intelligentie en cloud computing.